SEO業界に居ると、Webメディア企業の株価は非常に気になるものです。

自然検索経由のトラフィックが企業収益に大きく影響を与える為、SEOの成功可否が時間差で株価に反映されてきた事例を何度も目にしてきました。

その中、最近気になるのがカカクコム社の株価です。

出典:Google検索

ここ1年間で株価は1000円以上も値上がり、市場からの期待が高い事が見て取れます。

カカクコム社と言えば「価格.com」と「食べログ」がメインの事業であり、収益柱である食べログはGoogleMapという手強い競合が出現し、苦戦しているイメージでした。

新規事業「求人ボックス」が好調

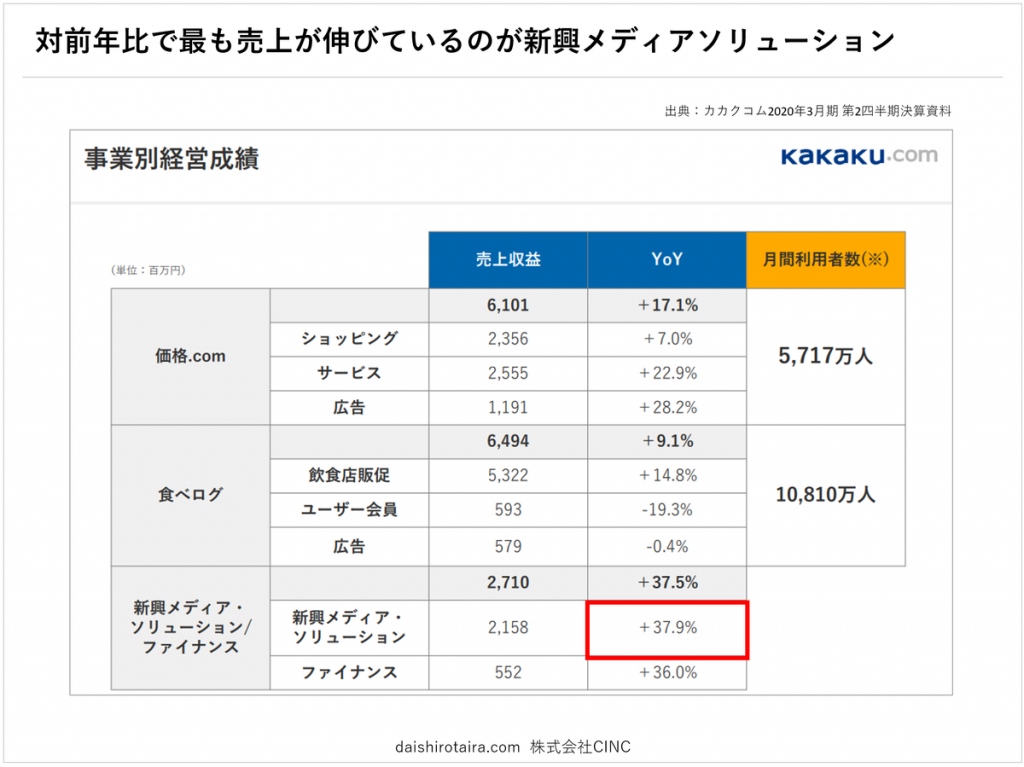

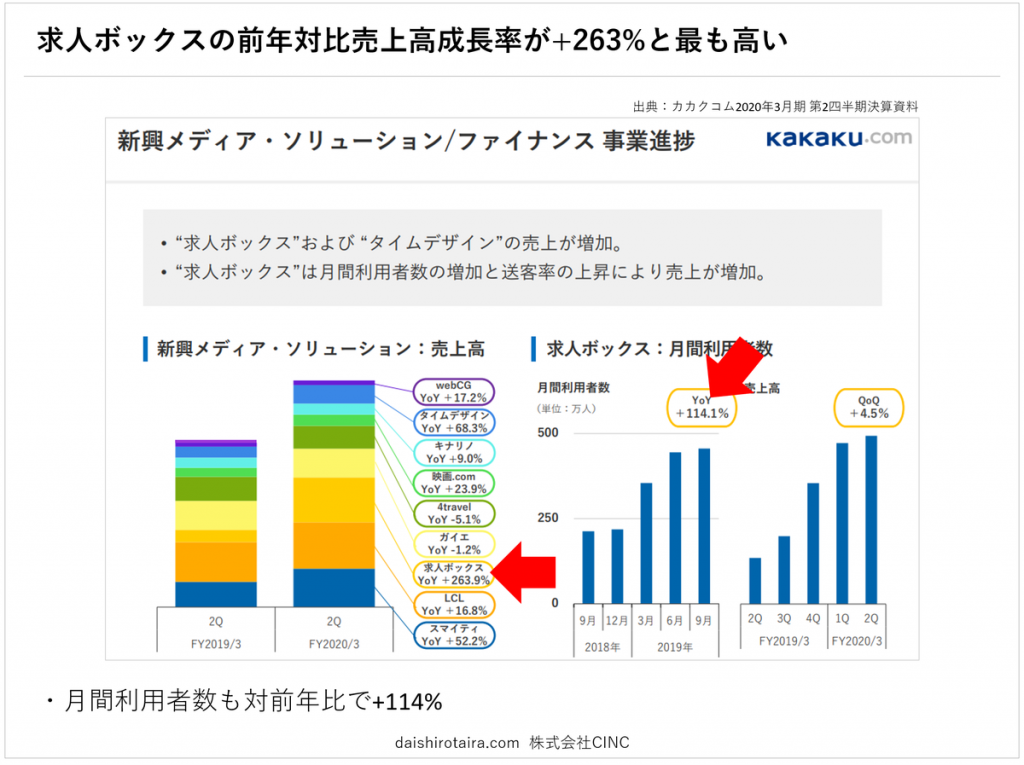

決算発表資料を見ると、各事業の中で「新興メディアソリューション」の前年対比成長率が最も高い事が分かります。

「求人ボックス」が前年対比で売上高が+263%と驚異的な成長を見せており、新興メディアソリューション事業の中でも次の収益柱として期待が持てる事業と言えるでしょう。

また、求人ボックスの月間利用者数は前年対比では+114%も増加しており、ここからも求人ボックスがトラフィックの獲得に成功し、広告型のビジネスモデルでしっかりと収益化が図れていると想定されます。

求人ボックスとは?

求人ボックスとは求人検索サイトの事で、Indeedやキャリアジェットなどの「アグリゲーションサイト」にカテゴライズされるDB系Webサイトの事です。

ドメイン取得日は2015年と日が浅く、カカクコム社のプレスリリースに出始めたのも2018年頃からと、まだ若い事業(Webサイト)である事がうかがえます。

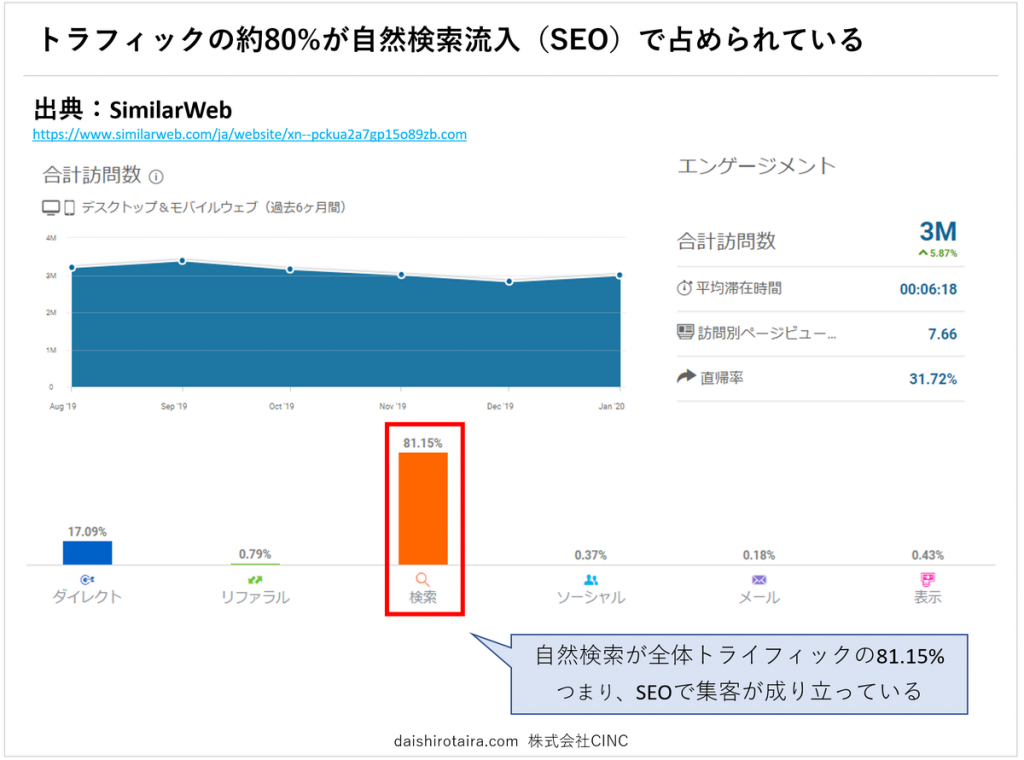

利用者数の急増を支えている集客源はどこなのかSimilarwebで調査した所、約8割が検索経由である事が分かりました。

また、Keywordmapの調査からPPC広告への出稿量も限定的である事から、殆どの集客を自然検索経由(SEO)で獲得している事が想定されます。

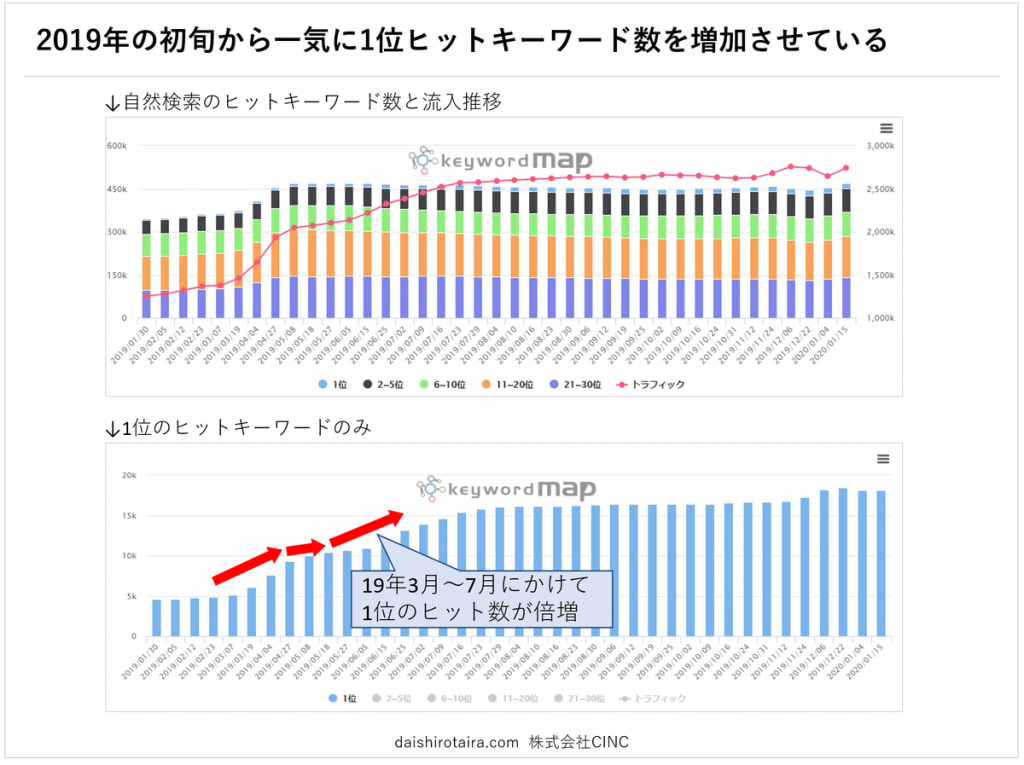

KeywordmapでSEOのヒットキーワード数の推移を調査した所、安定して検索順位を維持しており、昨年3月から7月にかけて1位ヒットキーワード数を大幅に増加させている事が分かりました。

この事からもカカクコム社の強みである「SEOノウハウ」が上手く機能し、集客獲得コストをほぼ0円で多くの見込み顧客を獲得する事に成功しているようです。

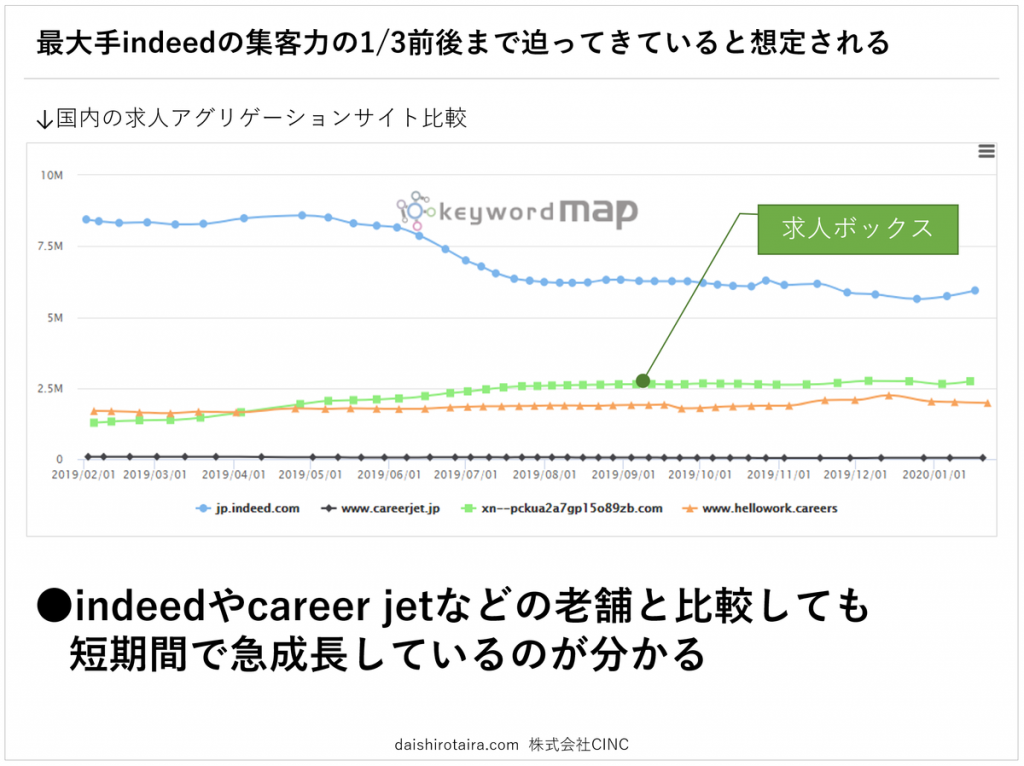

他のアグリゲーション競合サイトと比較しても短期間で急成長しており、Googleアルゴリズム変更の影響も大きく受けず安定的に成長しています。

最近ではWebCMもスタートしており、これにより「求人ボックス」というブランドの認知も拡大することでしょう。この認知拡大により利用者のハードルも下がり、多くの人が使うWebサービスへと成長していくと期待できます。

以上のように、2016年頃からスタートした求人ボックスは約3年でカカクコム社の次の収益柱へと急成長し、Webメディア事業におけるSEOの成功モデルとなるでしょう。

ではこの「アグリゲーションサイト」とはSEOの観点からどの様なサイトなのか、説明します。

SEOの観点から見るアグリゲーションサイト

アグリゲーションサイトとは何か

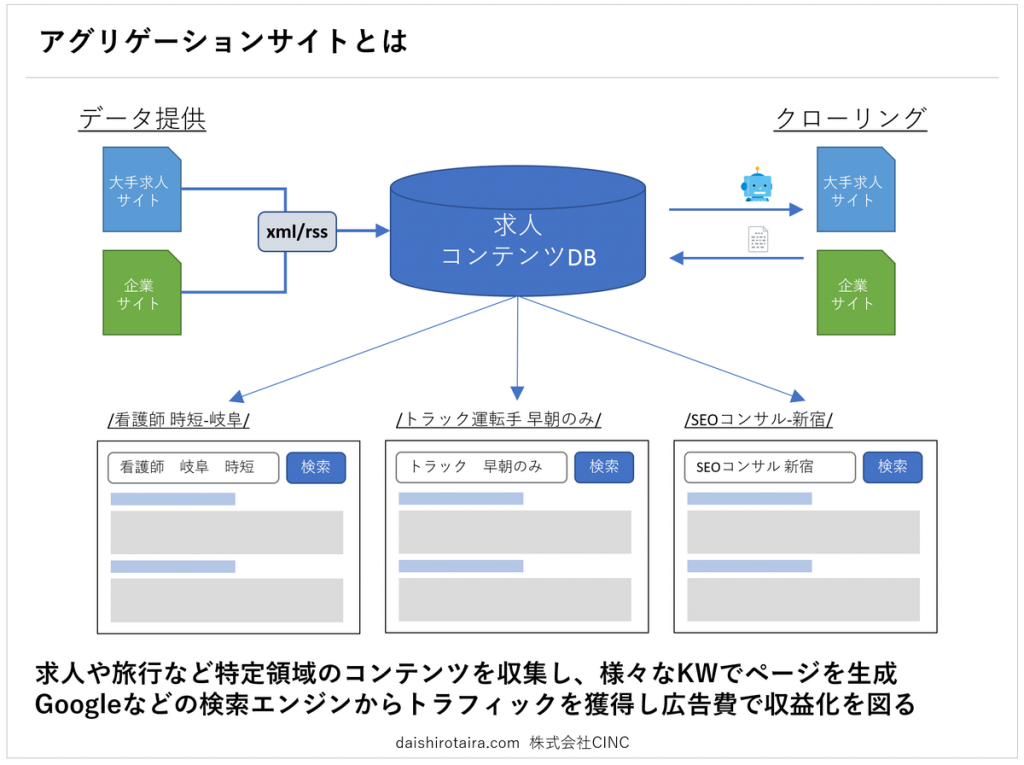

「アグリゲーションサイト」とは、他社のデータを集め、様々なキーワードでページごとに纏めて表示するWebサイトの事を指します。

掲載するデータそのものは他社のデータであり、アグリゲーションサイト側は「データの収集 → キーワードページごとの分割 → SEOでの集客」に徹します。

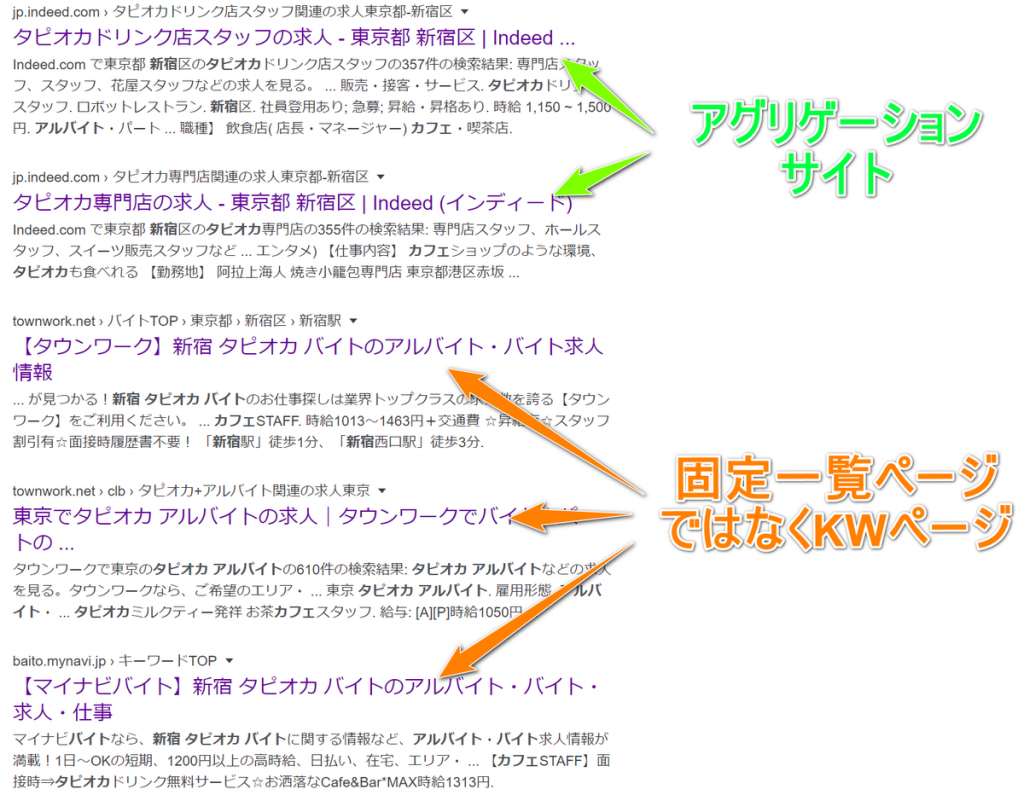

また、通常のDB型サイトとの大きな違いの一つに、「一覧ページが固定化されているか否か」が挙げられます。バイトルやタウンワークなどのDB型サイトの場合、Googleにインデックス化させる一覧ページは予め定められており、定めた検索組み合わせしかインデックス開放しません。

例:「新宿×カフェ」(https://townwork.net/tokyo/ct_sa52101/jc_001/jmc_00115/)

↑予め定められている検索組み合わせ。この範囲でしかindex開放されない。

「新宿×カフェ」との組み合わせは「週4」などの条件との組み合わせが約50前後発生していると想定されます。

もし「タピオカカフェ×新宿×バイト」という新しいキーワードをこの固定一覧ページで対策しようとした場合、予め定められている検索組み合わせを変更・追加する必要があり、データベースそのものを変更しなければならない為、実行難易度が高い施策と言えます。

事実、Googleで「タピオカカフェ バイト 新宿」と検索すると、固定一覧ページではなくアグリゲーションサイトや、アグリゲーションサイトの機能を持った「キーワードページ」が表示されます。

以上のように、アグリゲーションサイトとは生成する一覧ページをあえて制限・固定化せず、あらゆるキーワードでページを自動生成し検索クエリにヒットさせる事で、広く大量のトラフィックを獲得する構造にあるWebサイトの事を指します。

Webメディアのビジネスモデルから見ると、自らコンテンツは用意する必要が無く、ページは自動生成され、多くの自然検索流入を獲得できる夢のようなWebサイトのように見えますが、実装しSEO的に成功するには決して簡単な事ではありません。

いままでアグリゲーションサイトに事業参入した会社を多く見てきましたが、どのサイトも撤退を続けており、「SEOの解」を見つけるに至っていない企業が多い様に見受けられます。

では、このSEO難易度が極めて高いアグリゲーションサイトを構築するにはどうすれば良いのでしょうか。

自社サイトでアグリゲーションサイトの実証研究をしてみた

Indeed社やカカクコム社が持つ「アグリゲーションSEO」は門外不出のノウハウですから、外から見ていてもその方法論は推測の域を出ません。そこで、弊社が保有するWebサイトで実証研究をしてみました。

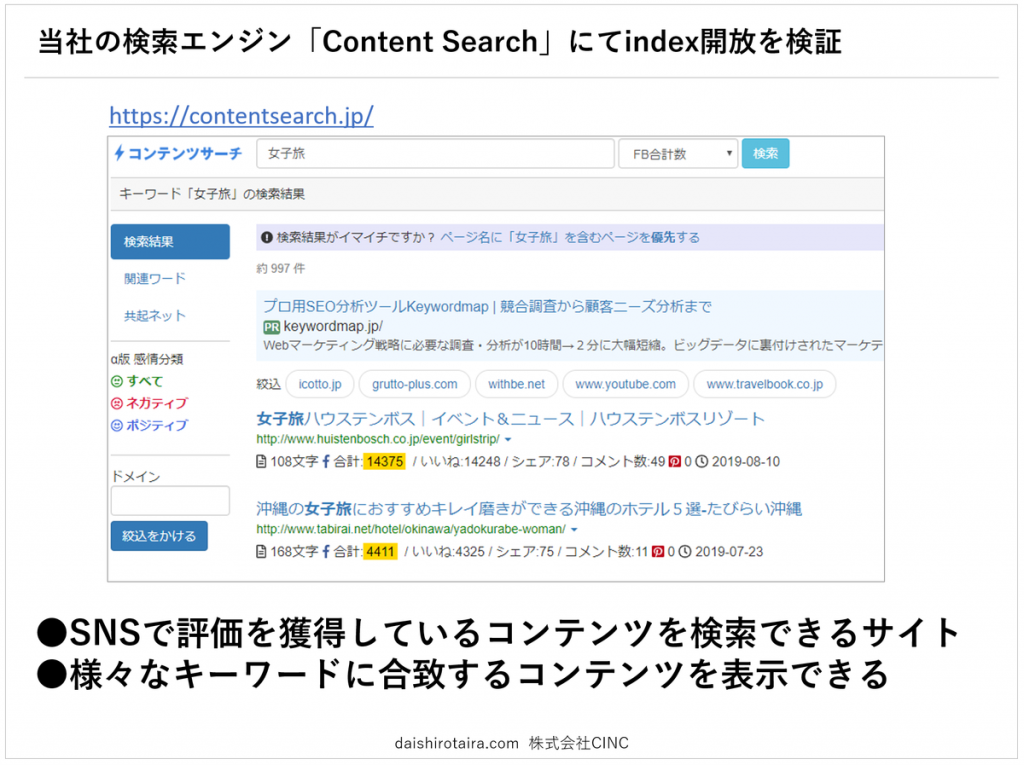

弊社ではコンテンツ検索エンジンContentSearchを保有しており、様々なキーワードでページを自動生成する事ができる状況にあり、こちらのWebサイトで検証しました。

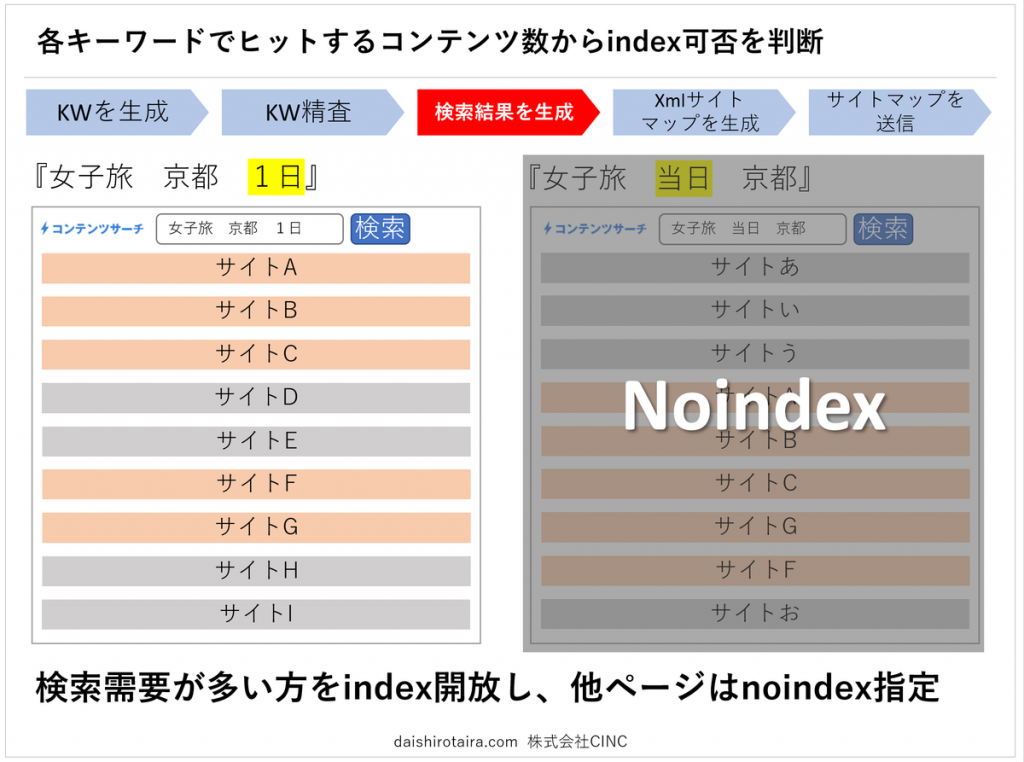

最も重視したのがindex開放するページの判別ルールでした。

むやみに全ページ開放した場合、大量の低品質コンテンツがindex化される事になり、順位上昇が見込めません。そこで、機械的に大量の一覧ページを生成しつつも、如何にルールベースでindex開放するページを判別していきました。

アグリゲーションサイトのシステム構築

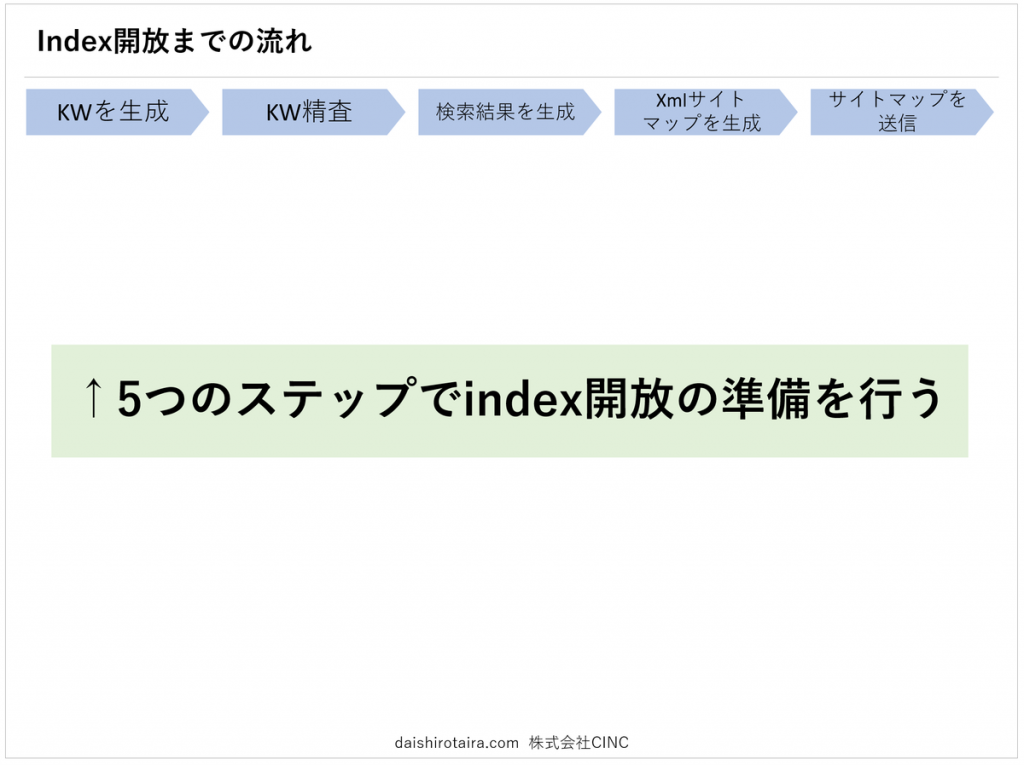

次にindex開放までの準備です。

キーワードの生成から精査、ページの生成、index/noindexの判定、xmlサイトマップの生成、送信などの作業を全てシステムで自動化しました。

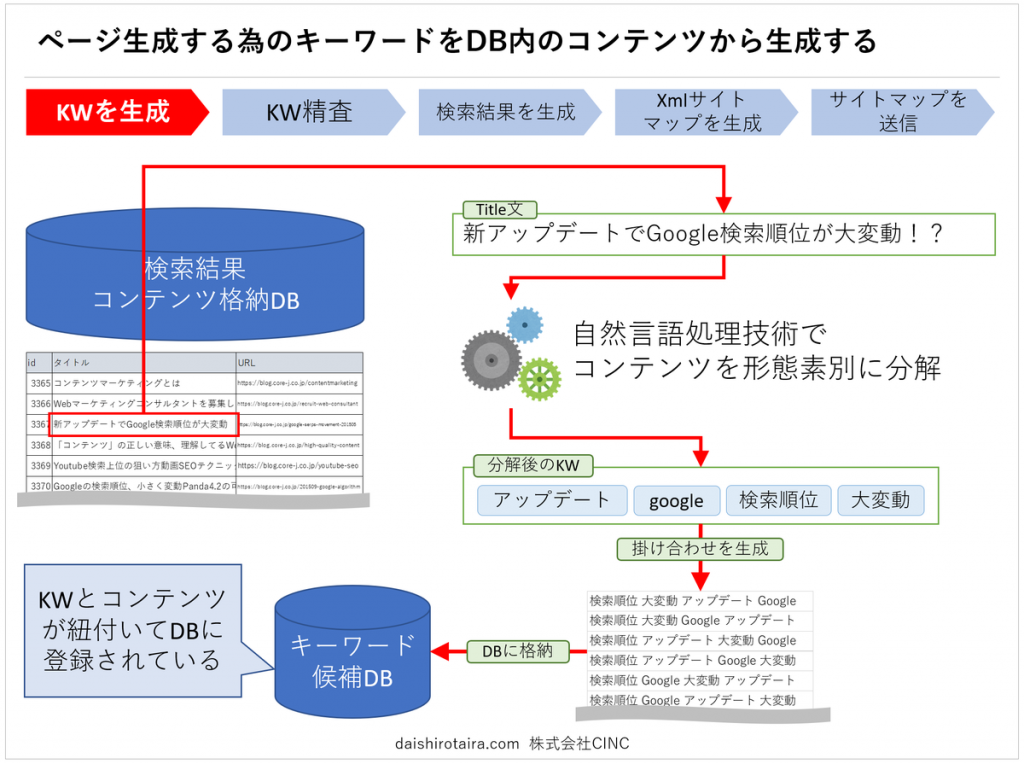

まずキーワードの生成です。

既に格納しているコンテンツから機械的にキーワードを抽出し、検索組み合わせを生成していきます。この際に利用したのがMecabと呼ばれる形態素解析エンジンです。

Mecabにコンテンツのタイトル文やディスクリプションを読み込ませる事で、単語として分解してくれます。この分解された単語を全通りのパターンで組み合わせ、DBに格納していきます。

標準のMecab辞書では新語(例「タピオカカフェ」)を適切に抽出できない為、独自で新語を登録した辞書を用意しました。

参考 共起語をより正確に抽出できるようになりましたKeywordmap

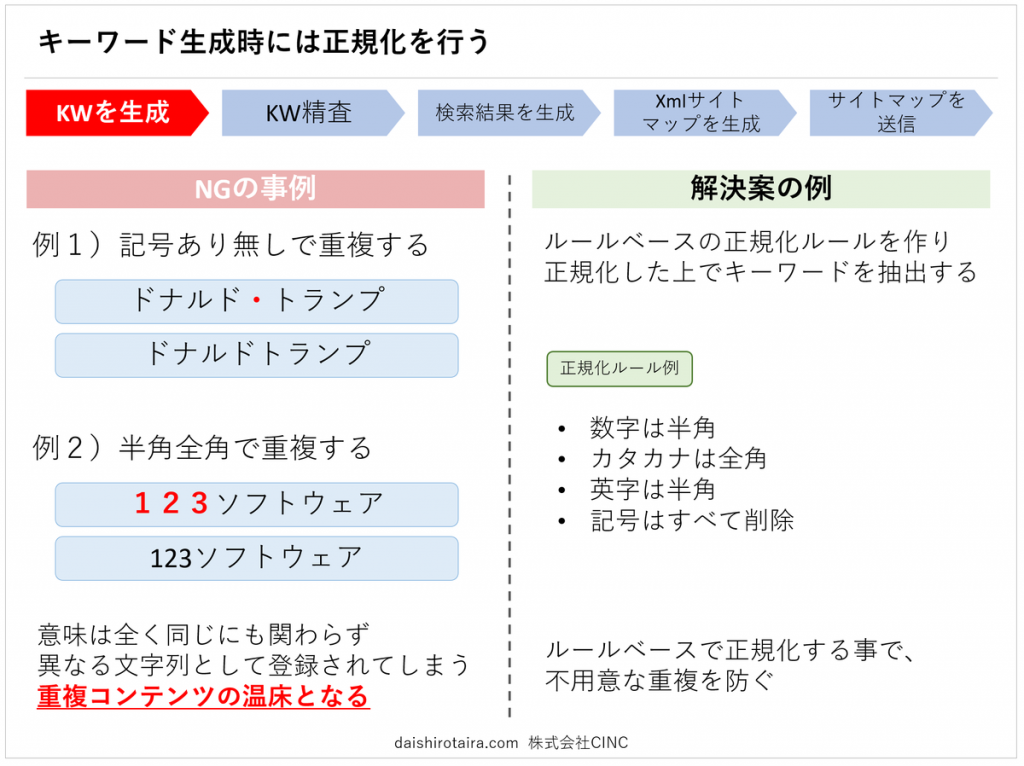

キーワード生成時に必ず「正規化」を行います。

例えば「ドナルド・トランプ」と「ドナルドトランプ」 が別々で生成された場合、同じ意味のページが少なくとも2ページ生成される事になります。この時点で重複コンテンツが発生し、SEO的なデメリットになります。

これら不用意な重複や低品質化を避ける為に、生成したキーワードを整え直す「正規化」の処理を施します。

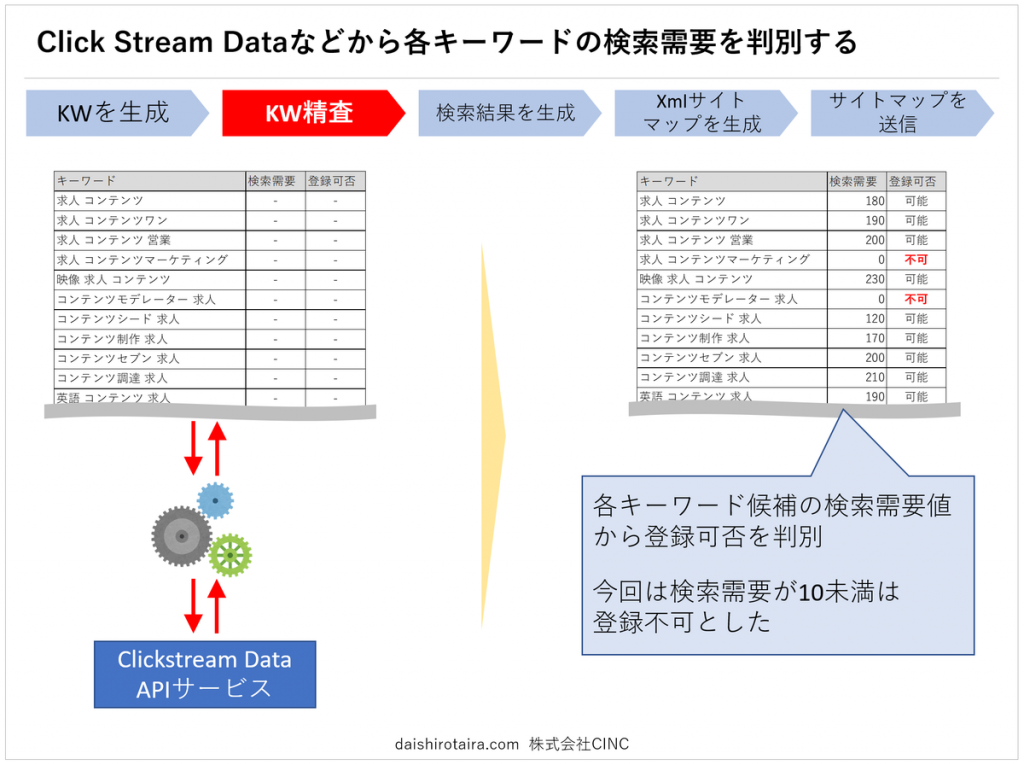

キーワードを生成したら、各キーワードに検索需要があるか確認します。この際に利用するのがClick Streamというキーワードごとの検索回数を示したデータを使います。これらデータは3rdベンダーによって販売されています。(例:AuthorityLabs )

検索需要(検索回数)で精査する事で、言葉として意味を成していないキーワードをほぼ抜けもれなく除外する事ができます。

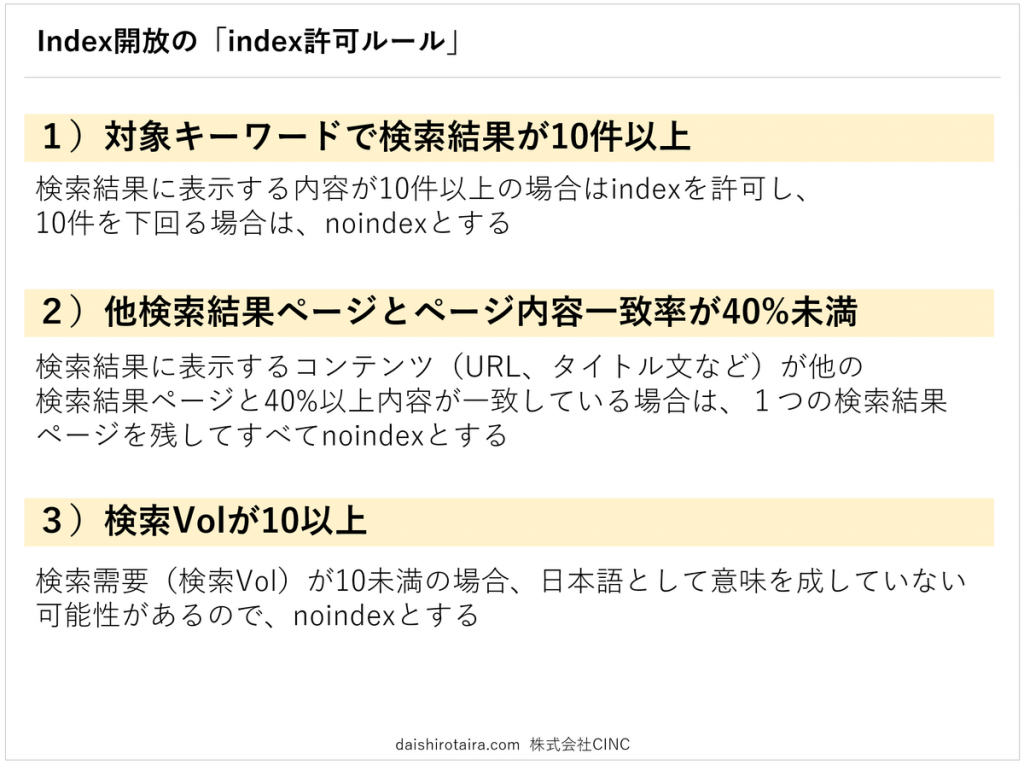

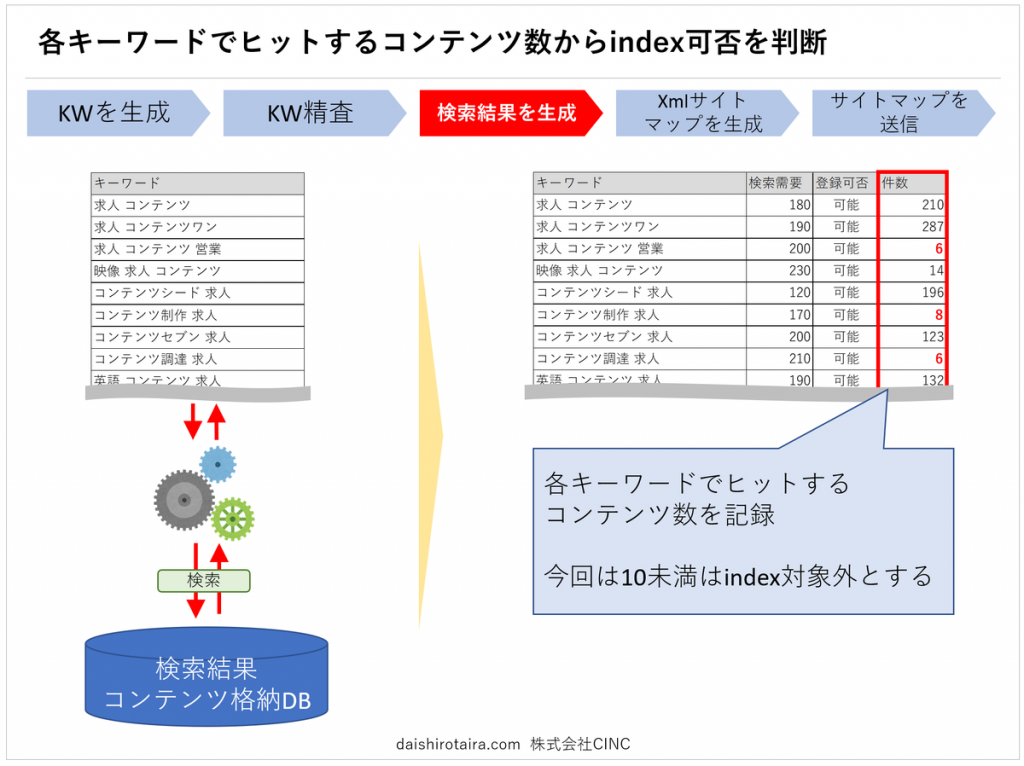

生成したキーワード候補から、そのキーワードで何件のデータがヒットするか確認し、DBに記録していきます。この記録した件数データをもとにnoindex/indexを出力させ、不用意な低品質コンテンツのインデックス化を防ぎます。

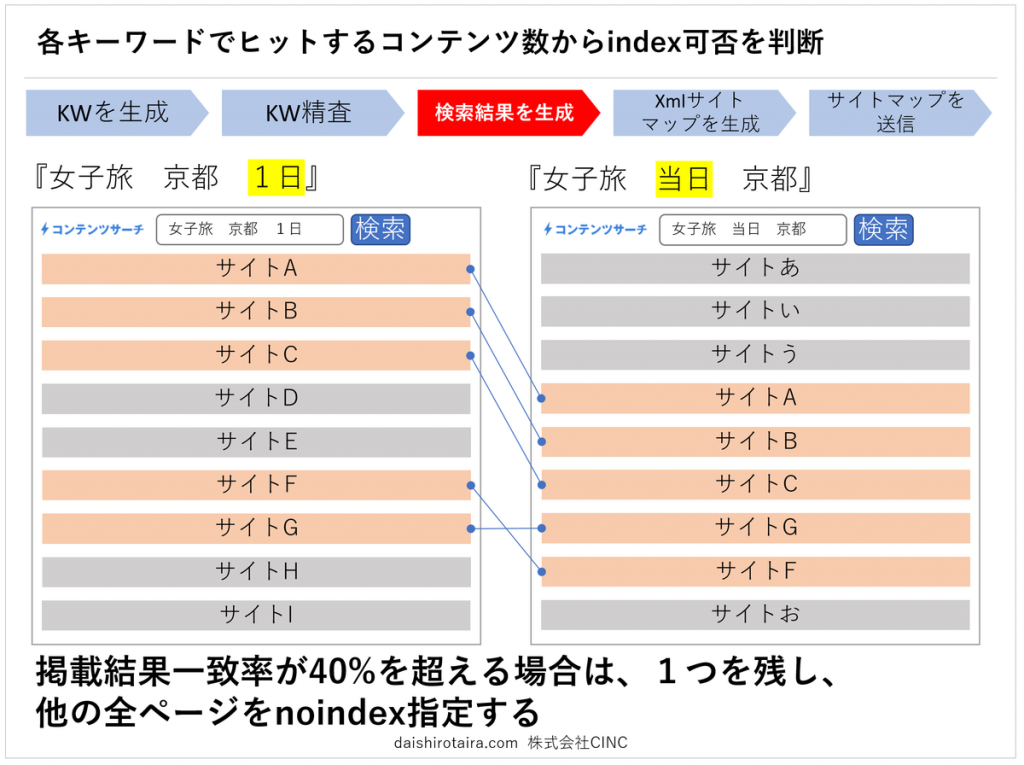

重複コンテンツ化を防ぐべく、各ページの掲載結果一致率を40%未満としました。各ページに表示される内容を全ページと比較し、40%以上一致しているページを機械的に抽出していきます。

重複率(類似率)が40%を超える場合、最も検索需要が大きいページのみを残し、その他のページは全てnoindexとしました。

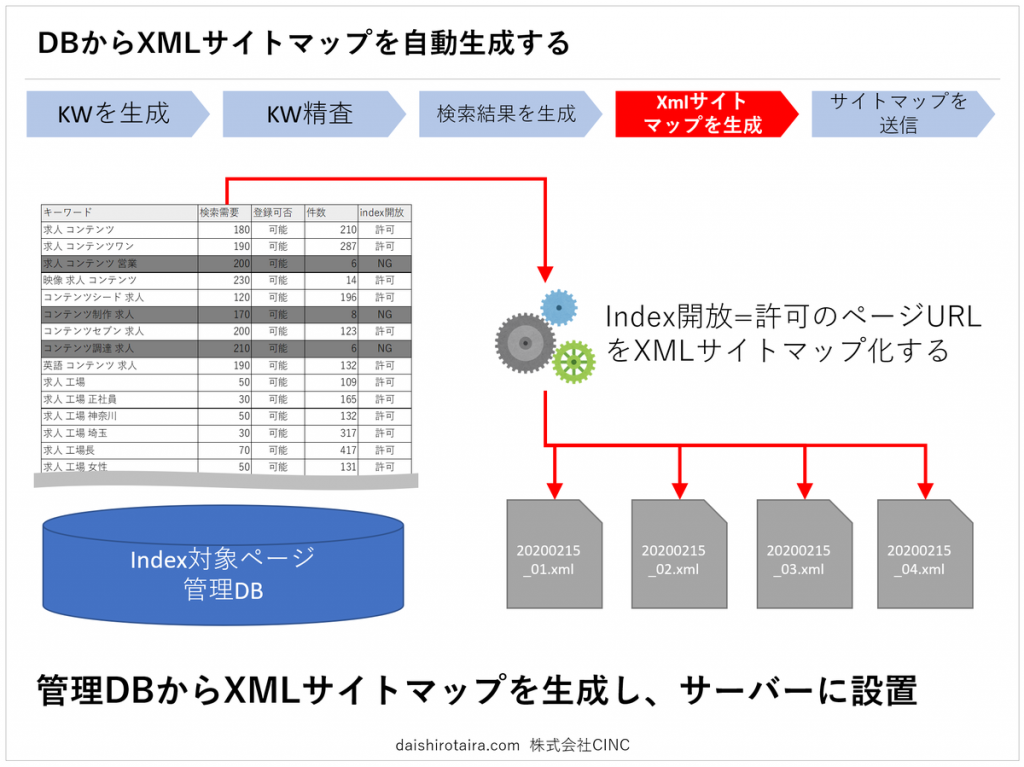

GoogleBotに大量のURLを検知しクローリングしてもらうべく、XMLサイトマップを生成していきます。対象となるURLが数十万URLも存在する為、全て機械的に生成しました。

キーワード候補を格納しているDBから「検索Vol が10以上」で「件数ヒット数が10件以上」のキーワードを抽出し、「https://contentsearch.jp/?q=$キーワード$」の形式でURLを自動生成しました。

URLも大量となると、XMLサイトマップも大量に生成されます。

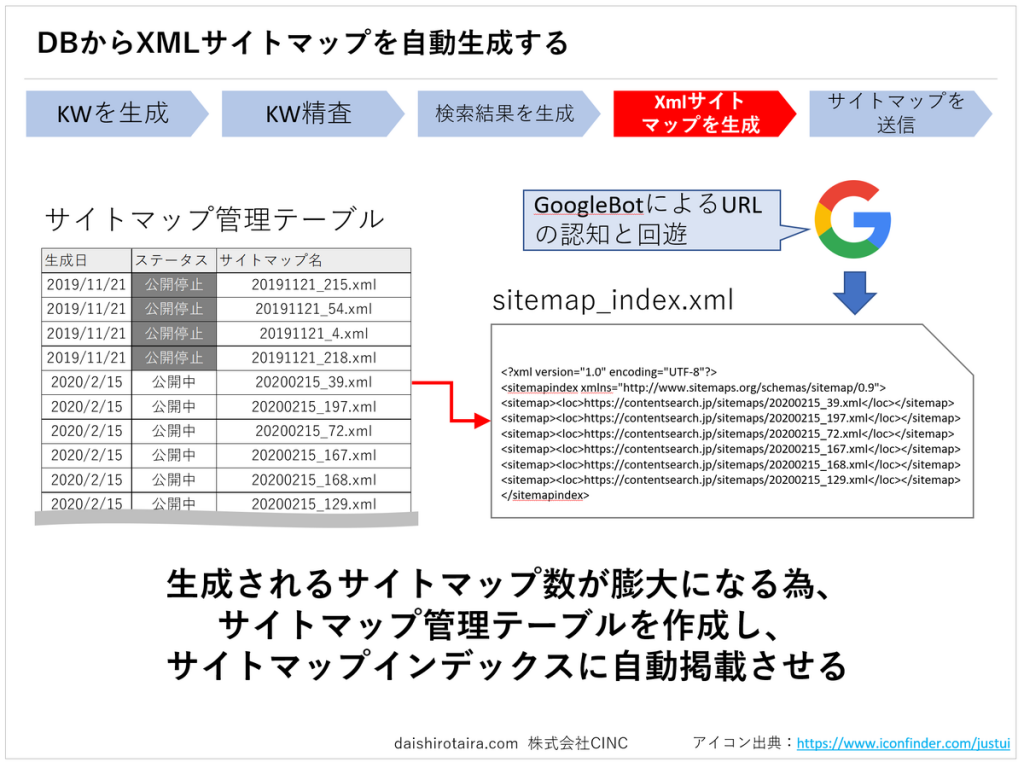

一つ一つのサイトマップをサーチコンソールから送信すると工数(手間)がかかるため、これらサイトマップをまとめる「サイトマップインデックス」を生成しました。

このサイトマップインデックス生成も、サイトマップを管理するDBから1日間隔で自動生成し、Webサーバー上に設置しました。

既にサイトマップインデックスはGoogleサーチコンソールから送信済みな為、個別のサイトマップのURLを毎度送ること無く、GoogleBotは新しいサイトマップの存在を検知する事ができます。

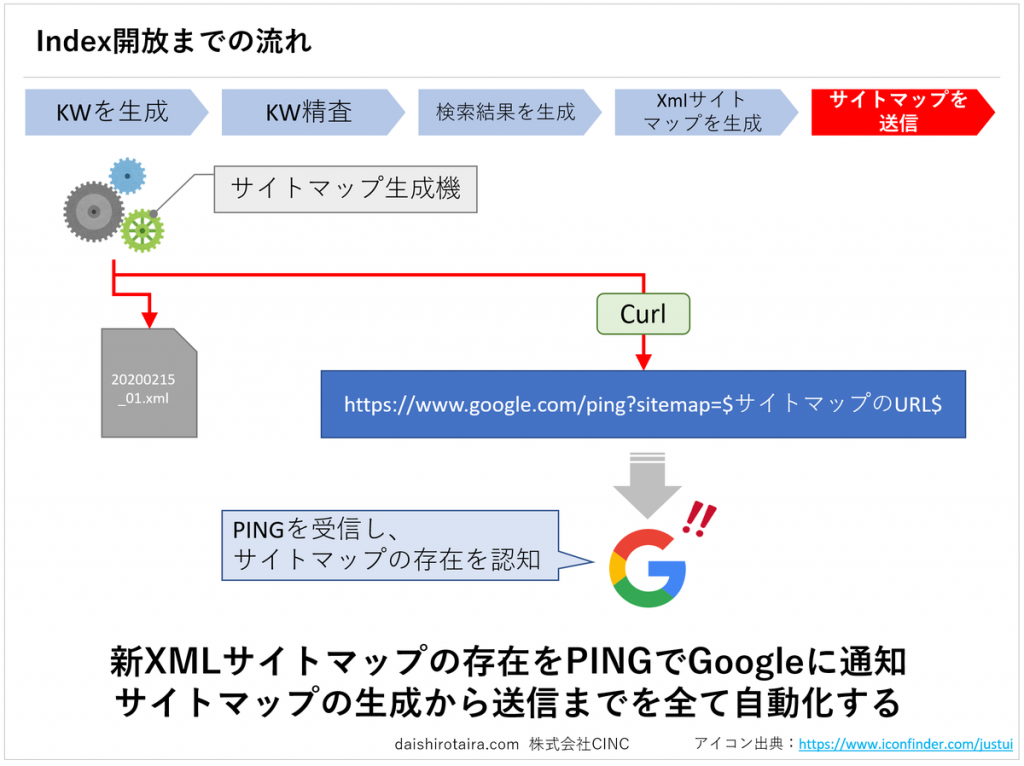

また、出来る限り早くGoogleBotにサイトマップの存在を検知しクローリングを開始してもらうべく、個別のXMLサイトマップをWebサーバー上に設置した際にGoogleにPINGも送信しました。これにより、Googleに対して新しく生成&設置したXMLサイトマップのURLを検知してもらう事が可能です。

以上のように、大量のページをいかに品質を担保しながら高速に生成していくかを技術面で実現し、準備しました。

実際のSEO効果はいかに!?

SEOの効果は…「一時的に予想以上の効果があったが、すぐに急落。ただ、SEOの学びもあり、参入テーマを絞って改善を積み重ねれば一定の事業成果も出せる」事がわかる実証研究でした。

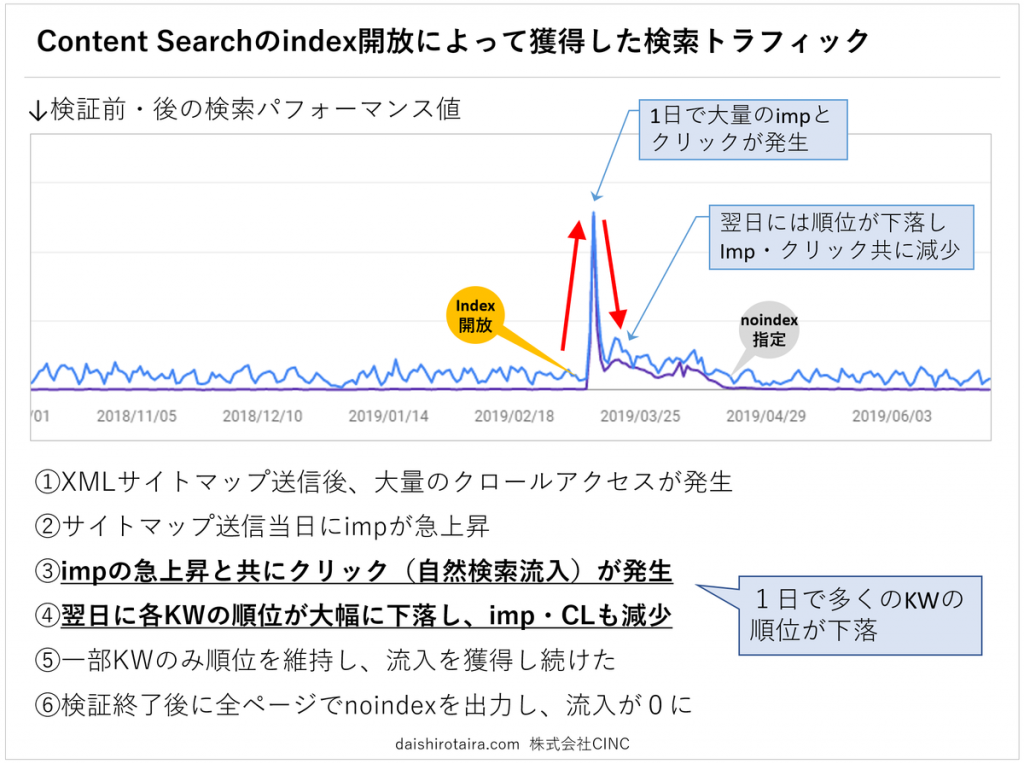

上の図はGoogleサーチコンソールの検索パフォーマンスデータです。(表示回数とクリック数の推移)

XMLサイトマップを送信直後にGoogleBotのアクセスが大量に発生し、数時間以内に大半のページインデックスがGoogle検索結果に出現しました。と、同時に多くのキーワードで上位順位を獲得し始め、検索結果上の表示回数とクリック数が急上昇。

当日は予想以上の検索トラフィックを獲得する結果となりました。

しかし、翌日になると多くのキーワードの検索順位が下落し、その後は回復せず。流入が一度も無かったページのNoindex化などを行い挽回を図りましたが回復が見られず検証から数週間後に全ページをnoindex指定し、実証研究を終えました。

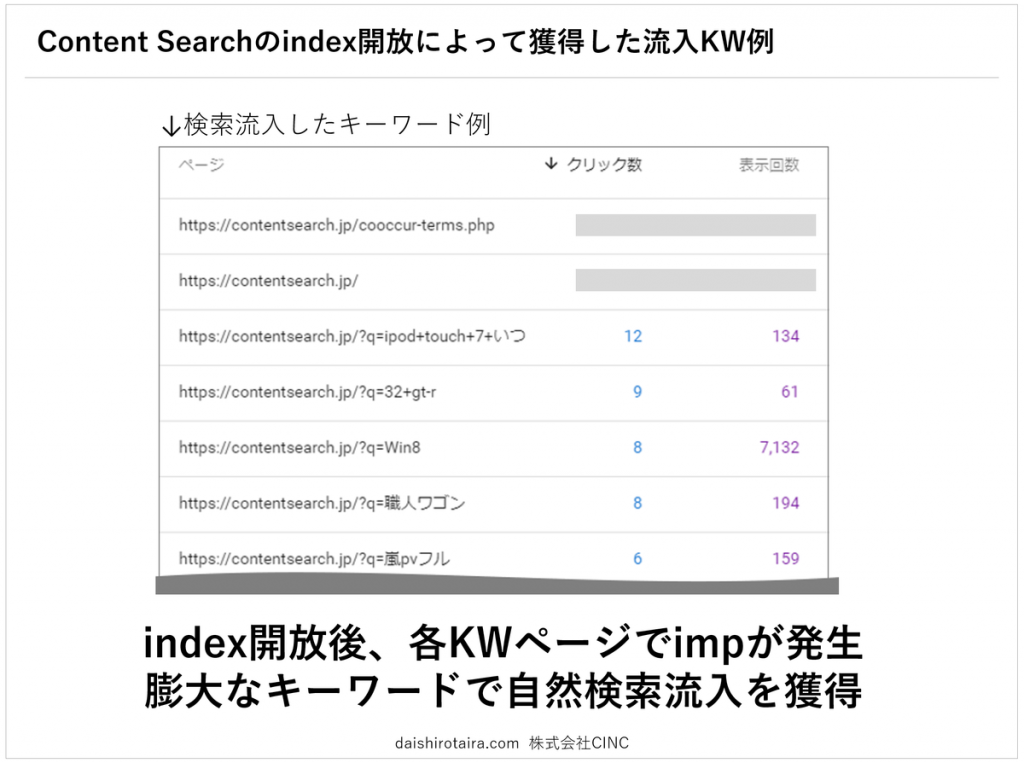

上の図は実際に獲得した自然検索流入です。

「ipod touch 7 いつ」や「職人ワゴン」など様々な検索クエリで表示回数とクリック数を獲得した事になります。

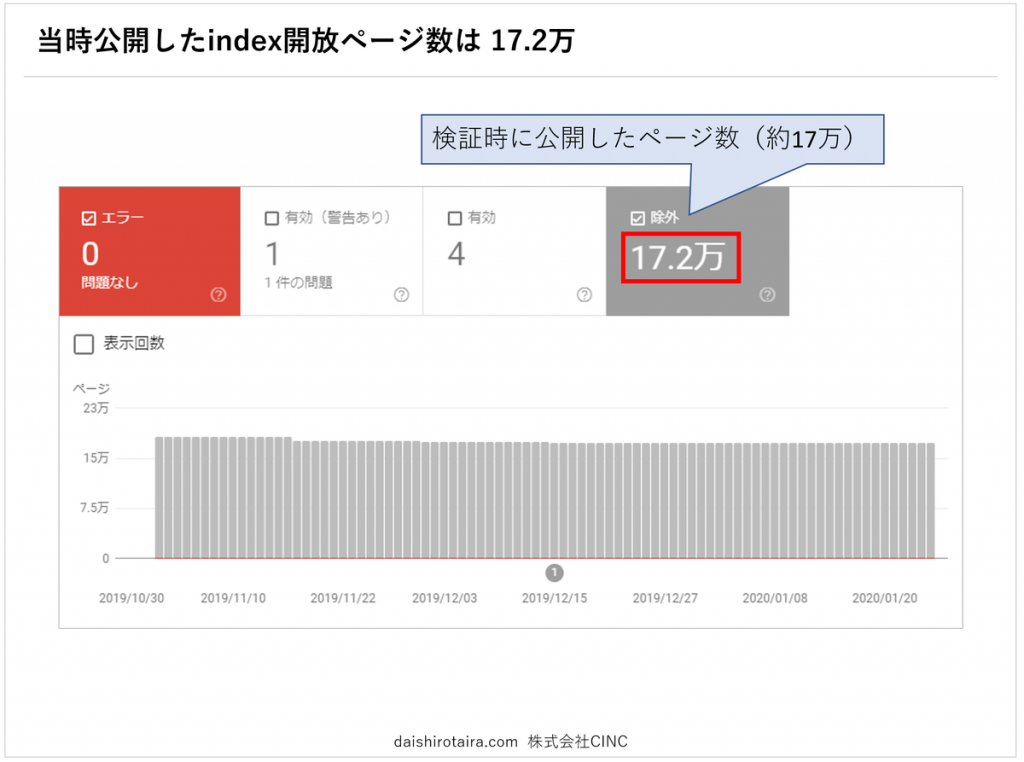

当時公開したページは約17万ページになり、その大半が1〜2日以内にインデックス登録されました。

現在は全ページNoindex指定されている為、サーチコンソールのインデックスカバレッジには「除外」扱いとなっています。

なぜSEO流入が1日で急減したのか?

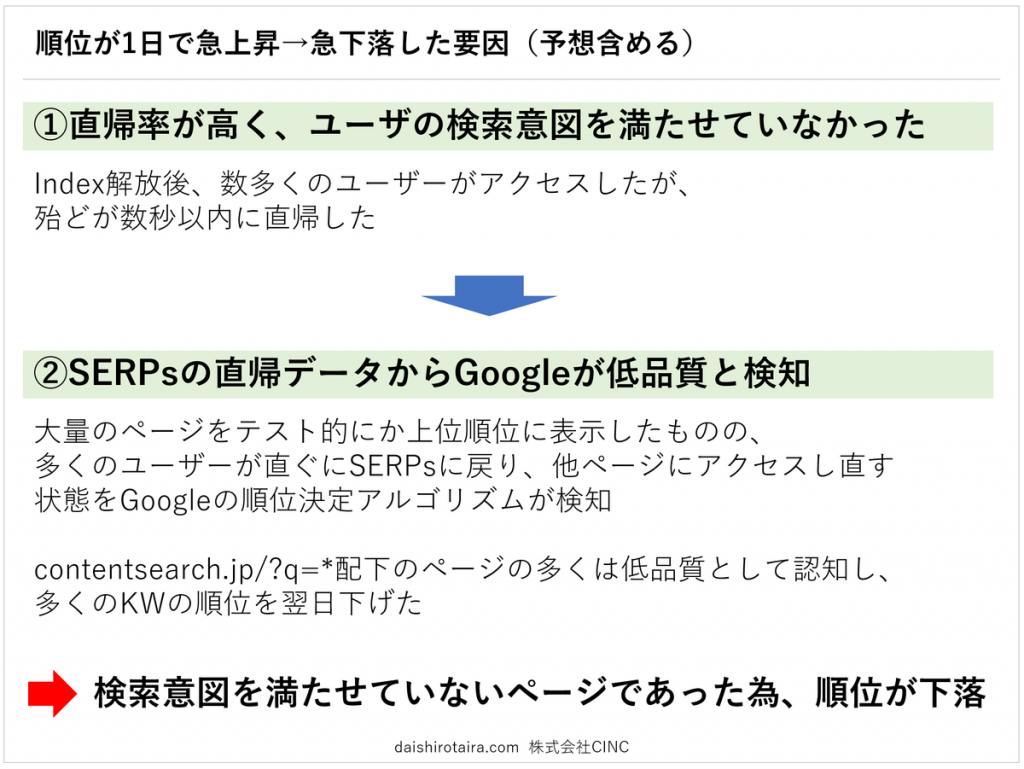

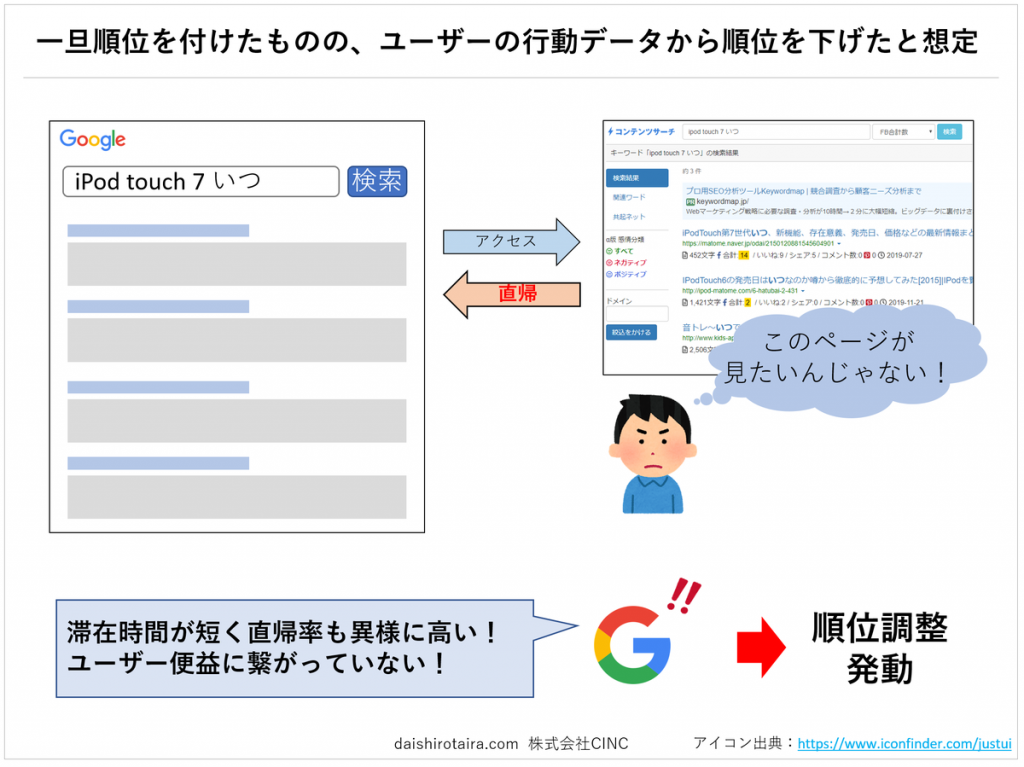

公開当日は成功したかのように見えた実証研究でしたが、1日でその流入も大幅に減少してしまいました。

では、なぜGoogleは当サイトの順位を上げた後に下落させたのか解説していきます。

結論を言うと「検索意図を満たせていないページだったから」になります。

Google検索結果から流入してきたユーザーの直帰率が95%以上と極めて高く、滞在時間も5秒未満が大半でした。この数字からもわかるように、ランディングしたユーザーの多くが当サイトのページ内容に満足できず、すぐに検索結果に戻ったと想定されます。

この「SERPへの直帰率の高さ」と「直帰までの時間の短さ」をGoogleのアルゴリズムが検知し、当サイトのコンテンツが検索ユーザーの意図や需要を満たせていないと判断したと思われます。

また、この異常値が多くのページで発生していた為、順位を付けてから1日も経たずに多くのキーワードで順位調整(下落)を施したものと想定されます。

今回の実証研究から「ユーザーの検索意図を満たせるページ機能」と「初回公開時の小さな検証と改善」の2点が重要である事が分かりました。

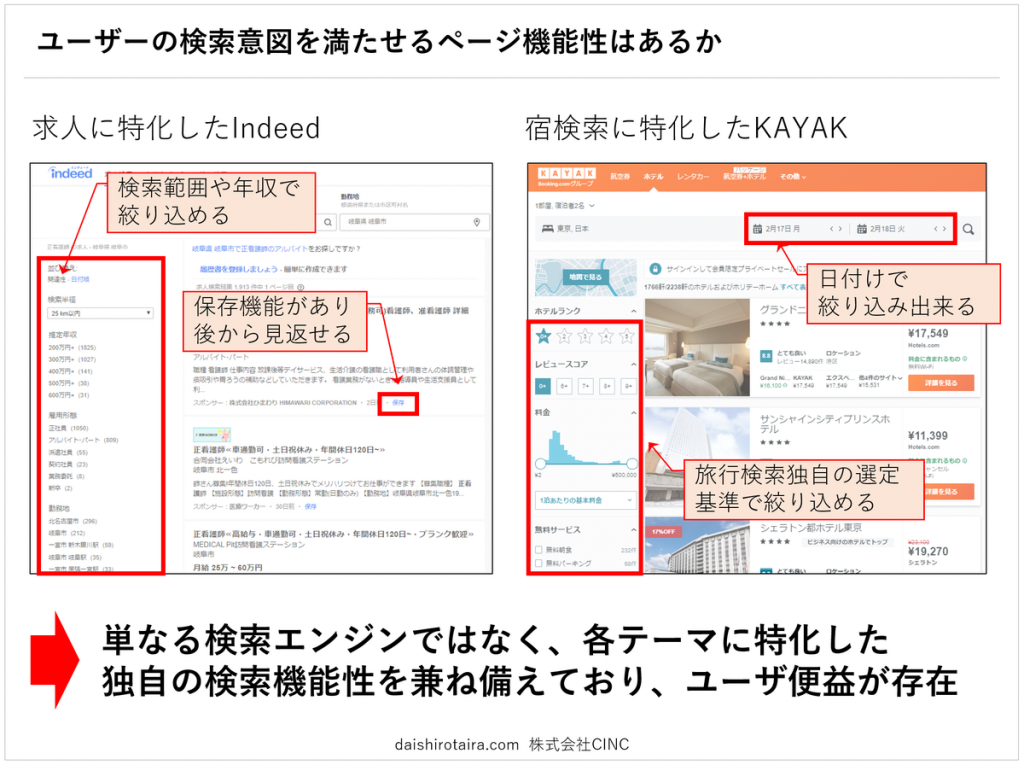

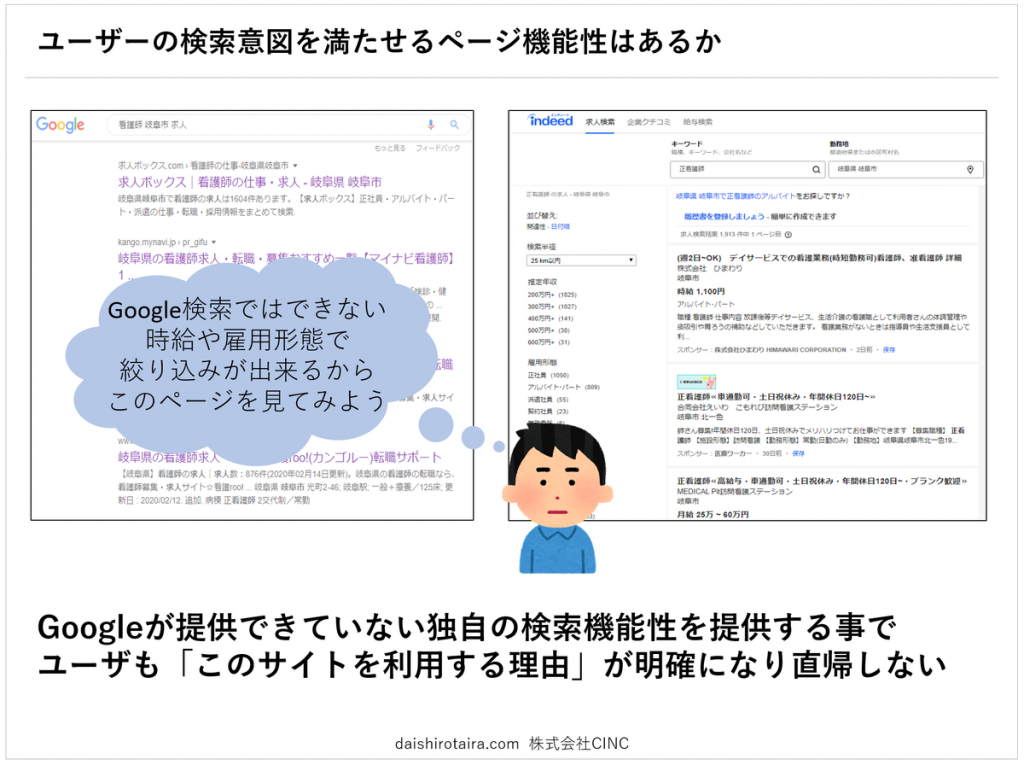

1)ユーザーの検索意図を満たせるページ独自の検索性はあるか

アグリゲーションサイトとしてSEO的に成功しているサイトの多くは、独自の検索機能性を持っています。

求人サイトのIndeedであれば、年収や時給、勤務場所、駅からの距離といった求人を選ぶ際に重要となる検索項目を設けています。

旅行時の宿検索に特化したKAYAKでは、宿泊する日付や1泊あたりの単価、「朝食あり」などの宿オプションなどから絞り込み検索する事ができます。

このように、単なる検索エンジンではなく、各テーマ(求人や宿検索)に特化した独自の検索機能性を備えており、ユーザーがそのアグリゲーションサイトを使う理由となる「便益」がしっかり存在している事が分かります。

この「独自の検索機能性=ユーザーがそのアグリゲーションサイトを使う理由=便益」が明確に存在する為、Googleの検索結果からアグリゲーションサイトへランディングしても直帰せずWebサイト内にとどまり続ける為、ユーザーの検索意図を満たしているページとなります。

このように、Google検索では検索しきれない独自の検索機能性をもたせ充実させる事で、ユーザーはそのサイト内にとどまり続け、直帰も発生しなくなります。

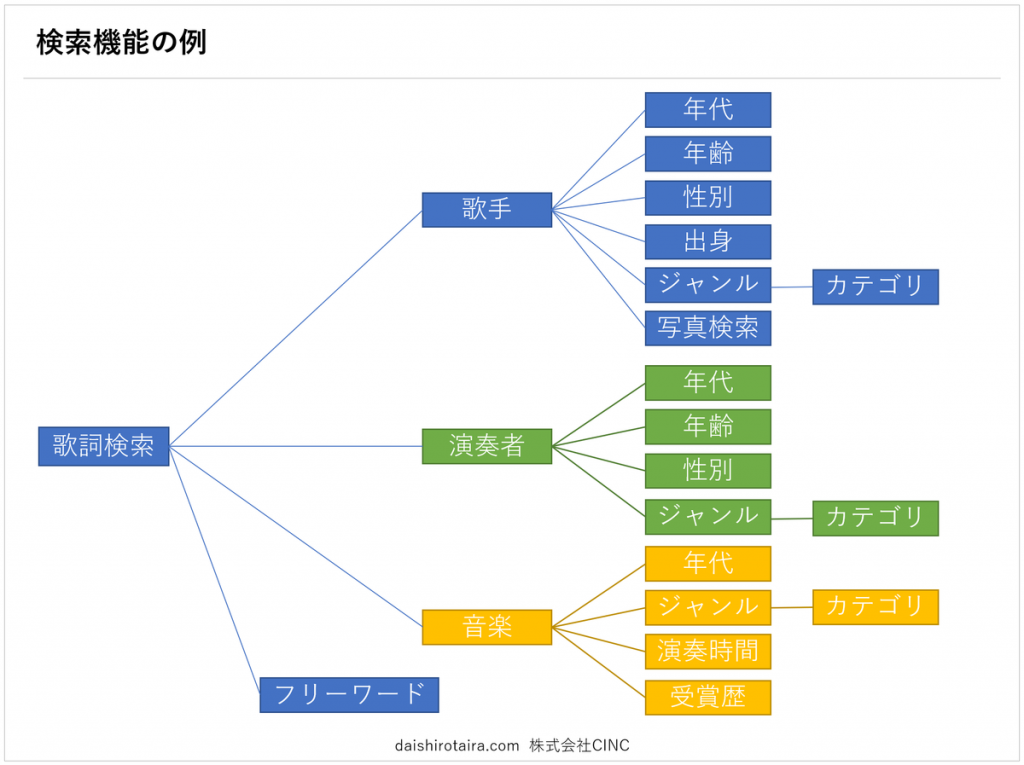

上の図は歌詞検索サイトの検索機能の例です。

「歌詞検索」という特殊なジャンルに絞る事で、「年代」や「演奏時間」「カテゴリ」など固有の検索軸をもたせる事ができ、ユーザーに便益を提供する事ができます。

この様に、アグリゲーションサイト事業に参入する際は、独自の便益を提供できる領域と、その領域に需要があるか、というマーケティング調査が必須となります。単にアグリゲーションシステムを構築しても、顧客である検索ユーザーが満足しない為、仮にSEO集客で成功しても、その先の広告ビジネスには結びつかないでしょう。

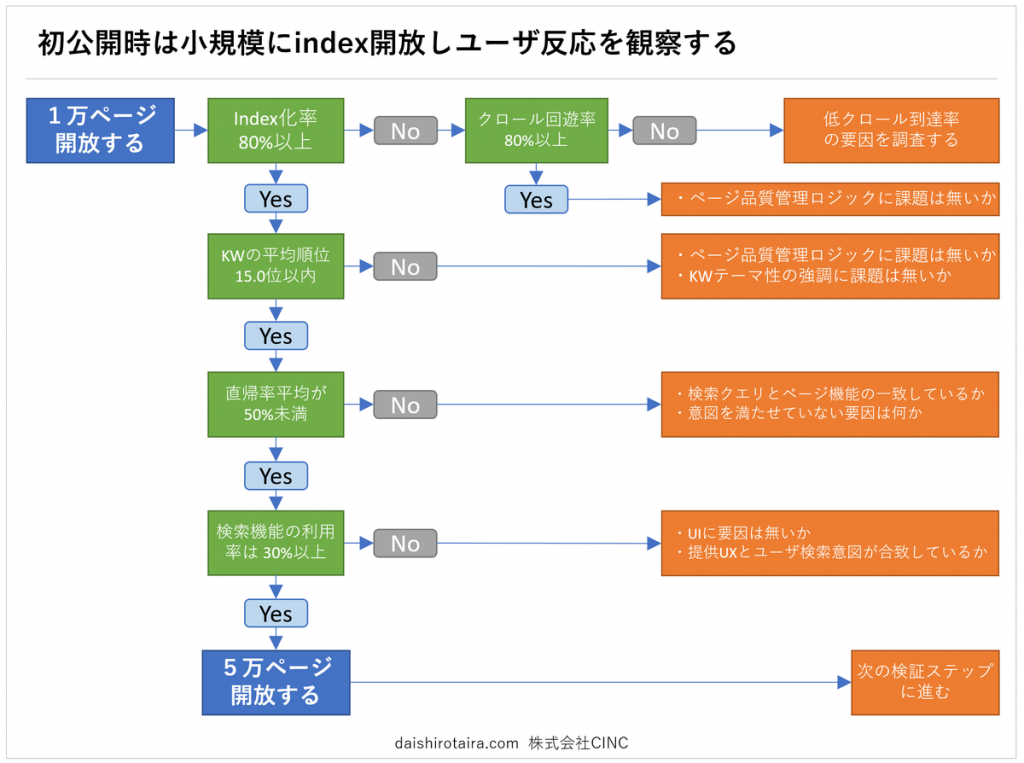

2)初回公開時は小規模にIndex開放し、ユーザーの反応を観察する

今回の実証研究では一度に数十万ものページを公開し、一気にユーザーの検索意図を満たさないページを公開してしまいましたが、決して数十万ものページを公開しなくともこの「検索意図を満たしていない」という事は分かったはずです。

この事からも一定のSEO勝ちパターンを見つけ出すまでには小規模にIndex開放し、各KPIの数値を観察し、改善する為の施策を高速で実施しながらKPIを向上させていく流れが望ましいでしょう。

上の図は初回公開時に定めておきたかった重要KPIの例です。

まずは1万ページのみを小規模に公開し、インデックス登録率をモニタリングしていきます。もし、インデックス登録率が低ければその要因を改善するフローに進みます。

インデックス登録率も高く検索順位も付いたものの、直帰率が高い場合はGoogleAnalyticsやヒートマップアクセス解析などを用いて、ユーザーの検索意図を満たせていない要因を調査し、改善へとつなげていきます。同時にユーザーヒアリングをしても良いでしょう。

「クロール到達率→インデックス化率→順位獲得率→ランディング数→直帰率」を改善し、基準をクリアしたら次の5万件を公開し再度同じKPIを観察する、といったSEO改善サイクルを何度か繰り返します。

複数回のサイクルを経て、各KPIで数値が担保できると確証を得た場合にはじめて全ページを一斉に公開し、自然検索流入を大幅に増加させるのが望ましいでしょう。

成功させるにはSEOノウハウと技術開発力が必須

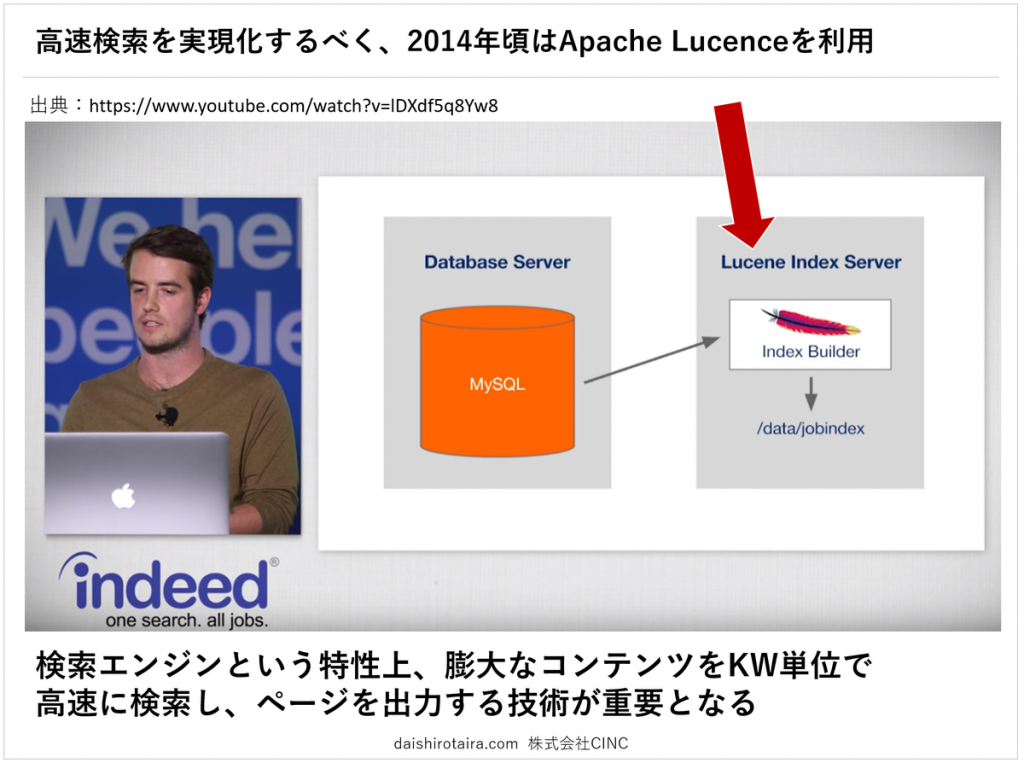

アグリゲーションサイトはサイトの特性上、「検索してページを出力する」という機械的な工程がページアクセスごとに発生します。膨大なデータからキーワードを軸に検索している為、本来であればページを生成するまでに一定の処理時間を要します。しかしページスピードが長いとユーザーの直帰を招いてしまう為、技術面で高速化ページ表示を実現しなければなりません。

2014年のIndeed社のエンジニアトークではApache Lucenceという全文検索エンジンを利用し、各検索モジュールごとにインデックスを構築していると発表されていました。

この様に、アグリゲーションサイトをSEO的に成功させる為には、キーワードの調査やUIUXの設計と合わせて、それを実現化させる技術的資産も重要になってくるという事が分かります。

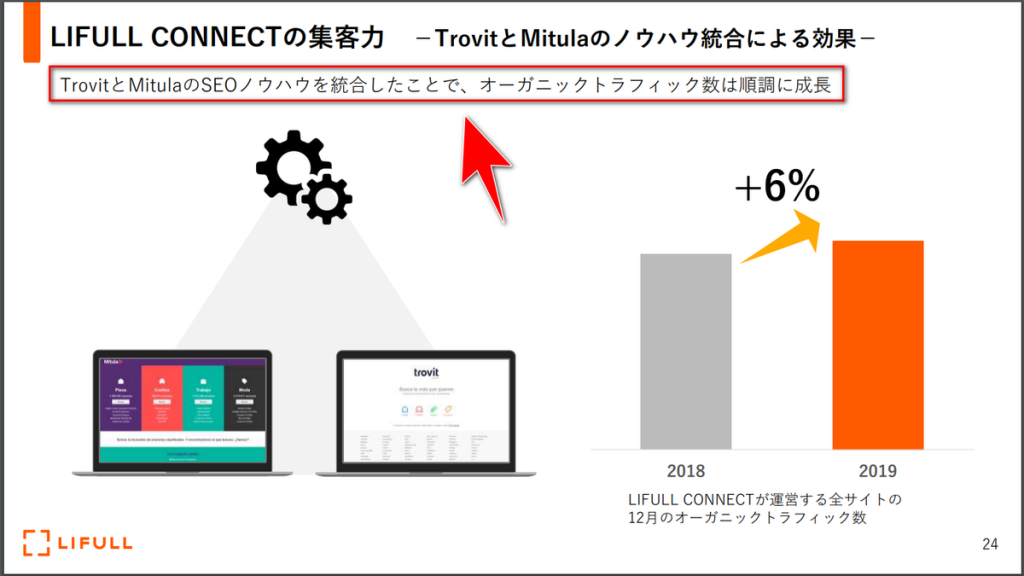

TrovitおよびMitulaを傘下に持つライフル社の決算発表資料には「TrovitとMitulaのSEOノウハウを統合したことで、オーガニックトラフィック数は順調に成長」と記載があります。

自然検索流入が業績に大きく影響するビジネスを展開している企業ほど、マーケティング的・技術的SEOノウハウを保有しており、再現性を持って他のWebメディアに展開したりし、収益拡大に成功しています。

Googleという手強い新たな競合

決してアグリゲーションサイトは安泰なビジネスモデルではありません。自然検索経由の集客を主体としている以上、Googleのアルゴリズム変更は業績に大きく影響を与えます。

しかし、アルゴリズム以上に手強いのがGoogle社による新規参入です。

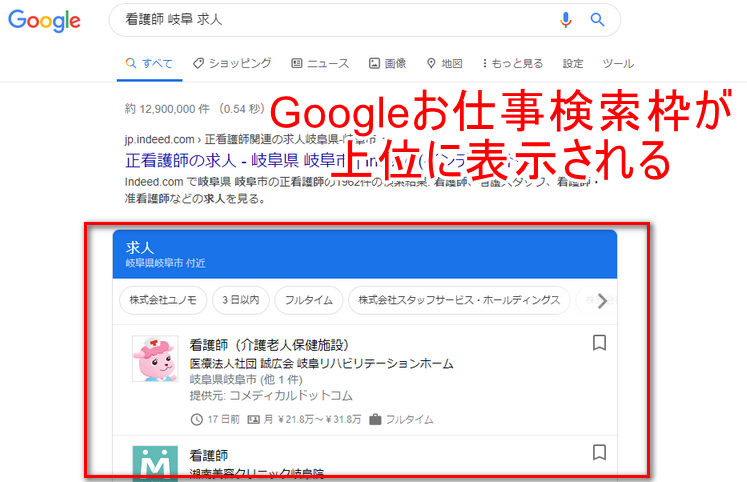

最近では求人検索に特化した「Googleしごと検索」をリリースし、自然検索枠にも表示し始めています。旅行業界に於いてもGoogle Travelをリリースしており、多くのユーザーが利用するサービスに成長しています。

Admarketechの記事によると、オンライントラベルエージェント大手のTripAdvisor社は業績悪化の為、200人の人員削減に踏み切ったようです。記事の中でTripAdvisor社はGoogleへ支払う広告費の増加が収益化に悪影響を来しているとの事。ユーザーとWebサイトの最初の架け橋である検索エンジンを握っているGoogleだからこそ、Google社の方針変更で既存事業の業績が大きく変化する企業も多数存在します。

Googleお仕事検索やTravelは既存アグリゲーションサイトにとって最も脅威となる存在でしょう。

SEOでどう事業のドライブと安定化を図るか

SNSが大幅に普及した現在も、自然検索流入は主要な集客源の一つです。

Mercari社やモノタロウ社などは今後の重要な事業戦略施策の一つとして「SEO」を挙げており、今でもSEOの影響力の大きさをうかがう事ができます。

Googleのアルゴリズム変更はもとより、Zero Click Searchなどの検索結果画面の方針変更や「Googleおしごと検索」などの固有検索領域への新規参入などGoogle1社による方針の変更で影響を受けやすいのも事実です。

事業の成長度合いで接触面を増やしていく

SEO1本に頼り切ってしまうとGoogle社の方針変更で経営が大きく傾きもすれば、飛躍する事もあり、不安定な経営を敷いてしまう事になります。

では、どうすればよいのでしょうか。

SEOは経営資源に左右されにくい施策

SEOの良い点の一つに「経営資源に左右されにくい施策」が挙げられます。

テレビCMやイベント開催などと比較し、SEOの実行には費用はさほど必要とせず、自社の資源コントロール内で実行できます。

スタートアップ企業から大手企業まで採用できる施策の一つであり、「良いコンテンツを作る」事に集中すれば、企業資本の大きさに関わらず無料でトラフィックを獲得できます。

しかし、良い反面、Google社の方針変更やアルゴリズムの変更により、ある日突然トラフィックを失い、企業経営が大きく傾く危険性も潜んでいます。事業が拡大し、経営に求められる要素が「成長」から「成長と安定・健全性」へと変化した際は、集客口の多様化・多角化も検討する必要があるでしょう。

今でもテレビの効果は高い

ネット、SNSと言われている現在も、テレビによる認知力は非常に強く、一般大衆を対象とするサービスの場合は、テレビCMによる業績の影響も大きいものです。

また、テレビCMを通してブランドやサービスの刷り込みを図る事で、指名系キーワードでの流入や直接アプリを開くユーザー行動を期待でき、集客口・接触口の多角化を図る事ができます。

リクルート社傘下のIndeedは日本で本格的に事業を開始して以降、TVCMを放映し、認知度を一気に上げています。

お笑い芸人や有名女優を採用し、インパクトある画と覚えやすい音程で刷り込みを図り、Google Trendの検索推移も右肩上がりで伸びている事が分かります。

「ルフィーのCMのサイト」という印象から「バイトを探すサイト」という印象を刷り込む事で、直接Webサイトを指名したり、アプリストアーで指名検索を誘発することが期待できるでしょう。

最後に

今回はSEOのモデルである「アグリゲーションWebサイト」を取り上げました。

各社それぞれの方法論やノウハウがある為、1つの正攻法がある訳ではありません。しかし科学的にGoogleを理解し、技術的にSEOにも適応したWebサイトを構築し、大量の見込み客を集客する手法は各企業の重要な知的財産とも言えるでしょう。

Googleとユーザーの両方を理解し、アグリゲーションモデルでSEO集客を図るのも一つの手としてお考え頂ければ幸いです。